Saat data adalah komoditas paling berharga, bentuk pengawasan baru bermunculan. Teknologi yang dikenal sebagai Pengawasan Emosi Bertenaga Akal Imitasi (AI-Powered Emotional Surveillance) kini merayap dari uji coba terbatas menuju potensi arus utama.

Metode ini jauh lebih invasif daripada sekadar melacak lokasi atau kebiasaan belanja daring, membawa serta ancaman mendasar terhadap kebebasan berpikir individu, otonomi pribadi, dan, pada akhirnya, fondasi demokrasi itu sendiri.

Bukan hanya masalah privasi data, teknologi ini, yang mampu membaca dan menginterpretasikan keadaan mental seseorang melalui data biometrik dan perilaku, dipercaya dapat mengancam agensi atau kemampuan individu untuk membentuk keputusan dan tindakan otentik mereka.

Informasi sensitif dari emosi yang terekspos berpotensi digunakan untuk menekan, memanipulasi, atau memaksa masyarakat untuk berpikir atau bertindak dengan cara tertentu, terlepas dari kehendak mereka.

Infiltrasi Batin: Bagaimana AI Membaca Emosi

Pengawasan emosi bertenaga AI bekerja jauh melampaui sistem pengenalan wajah konvensional. Sistem ini dirancang untuk menyusup ke pikiran manusia dengan membaca dan menganalisis emosi dari berbagai sumber data.

Data seperti ekspresi wajah, nada suara, tanda-tanda fisiologis (detak jantung atau respons kulit galvani), dan bahkan kata-kata tertulis pun dimanfaatkan. Setelah data terkumpul, algoritma AI menyimpulkan keadaan psikologis, preferensi, opini, bahkan kelemahan seseorang.

Penggunaan teknologi ini bukan lagi spekulasi futuristik. Berdasarkan analisis dari TechPolicy Press, beberapa uji coba telah dilakukan di seluruh dunia.

Di Tiongkok, misalnya, headband pemindai otak produk perusahaan rintisan Amerika, Brainco, diujicobakan pada ribuan siswa untuk mendeteksi yang kurang memperhatikan pelajaran. Tujuannya memaksa siswa tetap fokus, atau setidaknya, “berpura-pura” demikian.

Di Eropa, sistem kontrol perbatasan bertenaga AI yang disebut iBorderCtrl pernah diuji coba di beberapa negara Uni Eropa. Sistem ini dilengkapi kemampuan pengenalan emosi yang berfungsi layaknya “pendeteksi kebohongan” bagi warga negara non-UE yang ingin masuk ke wilayah tersebut.

Lebih lanjut, badan transportasi Transport for London bahkan melakukan uji coba pengawasan AI emosional di stasiun London Underground dengan tujuan mencegah kejahatan, mengukur kepuasan, dan memaksimalkan pendapatan melalui pemasangan iklan yang lebih tertarget.

Meskipun perusahaan yang mengimplementasikannya selalu mengklaim tujuan mulia—seperti keamanan, peningkatan efisiensi, atau pencegahan kejahatan—implikasi mendalam terhadap kebebasan individu sering kali diabaikan.

Emosi, pada dasarnya, adalah cerminan identitas seseorang, yang memberikan petunjuk sensitif tentang kondisi mental, pandangan politik, atau kerentanan psikologis. Kemungkinan pendeteksian informasi ini, atau bahkan hanya ancamannya, dapat disalahgunakan penguasanya.

Ancaman terhadap Otonomi: Hilangnya Kebebasan Batin

Inti dari ancaman pengawasan emosi AI adalah erosi terhadap otonomi pribadi atau privasi. Otonomi adalah hak mendasar setiap individu untuk bertindak atas kehendak dan penentuan diri sendiri, termasuk kebebasan untuk menyimpan pikiran dan emosi pribadi.

Ketika sistem AI dapat mendeteksi apakah seseorang merasa marah, kecewa, atau khawatir saat berada di ruang publik atau bahkan di tempat kerja, hal ini menciptakan kondisi di mana individu merasa harus menekan ekspresi emosional yang otentik, atau memalsukannya.

Demi menghindari dampak negatif, orang dipaksa berperilaku yang sesuai dengan harapan penguasa, atau korporasi. Karena, dampaknya bisa berarti tidak mendapatkan promosi, ditolak masuk ke suatu negara, atau menghadapi konsekuensi hukum.

Menurut Oznur Uguz dalam laporan TechPolicy Press (2025), pembatasan ekspresi diri semacam itu akan merusak inti dari otonomi individu. Seseorang mungkin terpaksa untuk meniru ekspresi yang “disetujui” oleh sistem.

Senyum saat diperiksa, antusiasme saat wawancara kerja, atau menampilkan ketenangan saat berbicara dengan pejabat pemerintah—bukan lagi karena ketulusan, tetapi karena takut konsekuensi buruk lantaran pembacaan yang tidak akurat atau “tidak pantas” oleh mesin.

Bahkan jika teknologi ini menjadi sempurna dan bebas bias, hal itu tidak membuatnya menjadi kurang menakutkan. Justru, akurasi yang tinggi akan membuat kita semakin terkurung. Ancaman pengawasan emosi ini memaksa kita untuk mengendalikan batin, merampas hak kita untuk menyimpan pikiran dan perasaan sebagai hak prerogatif pribadi.

Ini adalah bentuk pengawasan yang sangat personal, di mana yang dipertaruhkan bukan lagi sekadar data apa yang kita lakukan, melainkan siapa kita.

Efek Menakutkan dan Erosi Demokrasi

Pada skala masyarakat, potensi penerapan teknologi AI ini dapat menimbulkan efek menakutkan (chilling effect). Efek ini adalah situasi di mana orang merasa terpaksa untuk membatasi diri karena takut sanksi atau konsekuensi yang tidak terduga, bahkan saat sanksi belum diberlakukan.

Dalam konteks demokrasi, efek menakutkan ini merupakan racun yang mematikan. Demokrasi membutuhkan partisipasi publik yang bebas dan otentik, termasuk hak untuk memprotes, tidak setuju, dan mengekspresikan kritik.

Jika individu harus menahan atau menyembunyikan emosi yang menunjukkan ketidaksetujuan, keputusasaan, atau bahkan kemarahan terhadap kebijakan pemerintah, maka diskusi publik akan menjadi dangkal dan manipulatif.

TechPolicy Press dengan tegas menyatakan bahwa pada skala sosial, hal ini pada akhirnya akan menyebabkan erosi demokrasi (democratic erosion). Masyarakat dapat bertransformasi menjadi tiruan murah dari Oceania dalam novel distopia George Orwell, 1984.

Kita berisiko kembali ke era kuno yang menyimpulkan kecenderungan kriminal dari penampilan fisik seseorang—kini dilakukan dengan algoritma. Bayangkan saat wajah cemberut yang tidak disukai rezim dianggap indikasi “kejahatan pikiran” (face crime) dan harus dipenjara.

Celah Hukum dan Kegagalan Regulasi

Ketika berbicara tentang perlindungan, kerangka hukum yang ada saat ini, baik secara internasional maupun di banyak yurisdiksi nasional, terbukti tidak memadai untuk mengatasi ancaman spesifik dari pengawasan emosi AI.

Di Uni Eropa, yang sering dianggap sebagai pelopor dalam regulasi teknologi, Undang-Undang AI (EU AI Act) hanya melarang penggunaan sistem AI untuk menyimpulkan emosi secara sempit di area tempat kerja dan pendidikan, dan bahkan memberikan pengecualian untuk alasan medis atau keselamatan.

Penggunaan di area lain diizinkan, asalkan mematuhi persyaratan sistem AI berisiko tinggi. Pembatasan yang sempit ini meninggalkan celah besar yang memungkinkan penyalahgunaan pengawasan emosi di berbagai bidang penting lainnya.

Demikian pula, kerangka perlindungan data seperti GDPR memiliki penerapan terbatas—hanya berlaku untuk “data emosi” jika dianggap sebagai “data pribadi.” Namun, data emosi tidak selalu diakui sebagai data pribadi, meskipun kaitannya yang kuat dengan identitas seseorang.

Bahkan ketika dianggap pribadi, data tersebut mungkin tetap dapat diproses kecuali jika termasuk dalam kategori “data khusus,” yang tidak selalu berlaku untuk semua jenis data emosi.

Kurangnya ketegasan dalam mendefinisikan dan melindungi data emosi ini, ditambah dengan kerentanan instrumen hak asasi manusia yang hanya berlaku secara parsial dalam melindungi hak atas emosi kita, menciptakan “jalan keluar” bagi penggunaan berbahaya dari pengawasan emosi AI.

Uguz dalam TechPolicy Press menekankan bahwa celah hukum ini membahayakan tidak hanya privasi dan kebebasan berekspresi, tetapi juga otonomi, yang pada akhirnya dapat mengorbankan demokrasi.

Konteks Indonesia: Perlunya Kewaspadaan Regulator

Meskipun isu “pengawasan emosi” secara spesifik belum menjadi topik sentral di ruang publik Indonesia, ancaman umum AI terhadap demokrasi dan otonomi telah menjadi perhatian serius. Indonesia, yang tengah menyusun regulasi AI, telah mengakui perlunya pengawasan ketat.

Pemerintah, melalui berbagai kementerian, telah menyatakan bahwa penggunaan teknologi AI harus diawasi untuk mencegah penyalahgunaan yang melanggar peraturan perundang-undangan. Salah satu aspek utama yang menjadi perhatian adalah perlindungan masyarakat.

Setidaknya ada dua isu perlindungan, terkait penggunaan data dan memastikan AI tidak bertindak sebagai penentu kebijakan atau pengambil keputusan tanpa kendali manusia yang memadai, sebagaimana diulas dalam Panduan Penggunaan Generative AI oleh LLDikti Wilayah III.

Kekhawatiran yang serupa juga disuarakan oleh para akademisi dan pemerintah. Isu kurangnya transparansi model AI, yang sulit dipahami bahkan oleh pengembangnya sendiri, telah menimbulkan kekhawatiran tentang bias algoritmik dan potensi untuk membuat keputusan yang bias atau tidak aman.

Kurangnya transparansi ini diperparah dengan kerahasiaan yang sering menyelimuti produk-produk AI perusahaan teknologi besar, membuat masyarakat dan pembuat undang-undang sulit memahami ancaman yang ada.

Di tengah upaya untuk memperkuat karakter bangsa dan nilai-nilai luhur, Deputi Bidang Koordinasi Revolusi Mental Kemenko PMK, Warsito, bahkan pernah menilai kemajuan AI dapat mengikis karakter bangsa Indonesia dan mengancam nilai-nilai Pancasila, terutama melalui ideologi transnasional.

Respons terhadap tantangan ini diwujudkan melalui pengembangan Strategi Nasional Kecerdasan Artifisial Indonesia (Stranas KA) sejak 2020. Dirjen Informasi dan Komunikasi Publik Kemenkominfo, Prabu Revta Revolusi, menegaskan regulasi AI disusun untuk melindungi masyarakat dari dampak negatif AI dan menjunjung nilai Pancasila, sebagaimana dilaporkan RRI, 25 Oktober 2024.

Kekhawatiran ini menggarisbawahi pentingnya Indonesia tidak hanya berfokus pada AI secara umum, tetapi juga secara khusus menyikapi potensi pengawasan emosi. Isu-isu seperti penggunaan sistem pengenalan wajah di ruang publik tanpa payung hukum yang jelas adalah langkah awal menuju pengawasan yang lebih mendalam, termasuk pengawasan emosi.

Siapa yang menyimpan data biometrik tersebut, dan siapa yang boleh mengaksesnya, menjadi pertanyaan krusial yang harus dijawab. Pengawasan emosi bertenaga AI adalah tantangan baru yang mengubah permainan, menambah rumit konteks dari apa yang kita lakukan menjadi apa yang kita rasakan di dalam hati.

Jika regulasi tidak segera dan tepat diberlakukan, kita berisiko mendapati diri kita terjerumus ke dalam dunia di mana keharusan untuk menyembunyikan atau memalsukan perasaan menjadi satu-satunya cara untuk melindungi integritas mental dan privasi kita.

Ancaman ini sudah semakin dekat, menjadi potensi ancaman yang semakin nyata, terbukti dari uji coba berkelanjutan di berbagai sektor di seluruh dunia. Keraguan untuk bertindak sekarang dapat membawa kita selangkah lebih dekat ke “dunia pikiran yang dipenjara”.

Bila itu terjadi, kebebasan sejati, baik otonomi pribadi maupun demokrasi, akan hilang, tidak karena paksaan fisik, tetapi karena pengawasan emosional tanpa henti oleh mata-mata buatan.

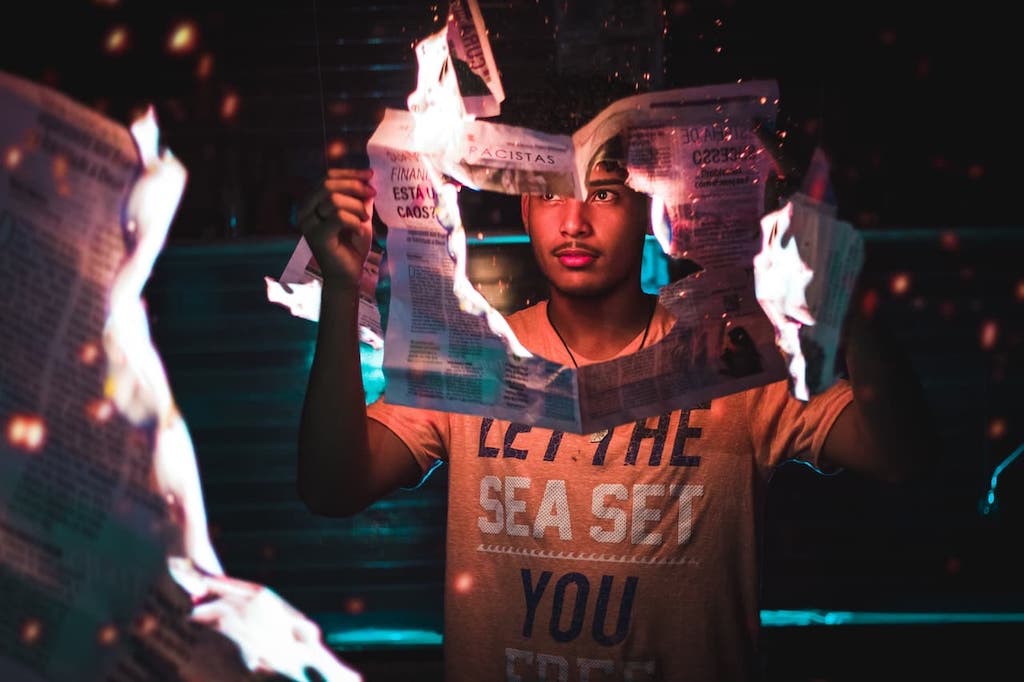

*Photo by Andre Hunter via Unsplash