Kita kebanjiran informasi, tapi akurasinya meragukan. Perlu tolok ukur yang jelas untuk mengevaluasi dan mendeteksi konten-konten buatan AI. Bila tidak, semakin sulit membedakan konten yang menyesatkan.

Meski teknologinya makin maju, alat deteksi AI payah di dunia nyata. Banyak faktor menyebabkan “kesenjangan kesetaraan deteksi”. Sebut saja kualitas media yang rendah, manipulasi berlapis-lapis, minimnya data pelatihan untuk bahasa dan konteks lokal, hingga aksesibilitas dan keadilan.

Misalnya satu model deteksi yang tidak berdaya ketika dihadapkan pada teks yang dihasilkan oleh model AI yang berbeda. Detektor teks yang dilatih secara spesifik dengan satu jenis model AI, seperti ChatGPT, loyo ketika berhadapan dengan teks produk LLaMA.

Teknologi deteksi pun seringkali berlomba dengan perkembangan model bahasa besar yang sangat cepat. Dalam hitungan bulan bisa muncul model baru dengan teknologi baru, membuat detektor AI ketinggalan zaman.

Lalu ada problem lain: Alat deteksi hanya berkinerja baik pada materi beresolusi tinggi dan hampir asli. Sementara di dunia nyata, pemeriksa fakta dan jurnalis berhadapan dengan video berkualitas rendah, terkompresi, atau pengambilan gambar yang buruk.

Kasus-kasus seperti video AI yang diduga menunjukkan seorang presiden mengonsumsi kokain atau rekaman percakapan radio selama konflik, sering kali tidak dapat dianalisis secara konklusif oleh alat yang ada karena kualitasnya buruk, atau mengandung anomali.

Sebaliknya, ada masalah saat konten asli secara keliru dicap sebagai buatan AI, seperti yang terjadi pada video kandidat wakil presiden Ghana yang dianggap deepfake padahal asli. Hal ini mengikis kepercayaan publik, menyoroti perlunya alat yang akurat dan dapat dipertanggungjawabkan.

WITNESS, sebuah organisasi nirlaba yang berfokus pada penggunaan video untuk hak asasi manusia (HAM), telah merilis laporan penting yang memperkenalkan konsep Truly Innovative and Effective AI Detection (TRIED). Setidaknya begitulah klaim mereka.

WITNESS berdiri sejak 1992, berkantor pusat di Brooklyn, New York, Amerika Serikat. Mereka memberdayakan individu dan kelompok di dunia agar dapat menggunakan video dan teknologi dalam mendokumentasikan pelanggaran HAM.

Bagaimana Tolok Ukur TRIED Bekerja

Di satu sisi, ada inovasi yang terus mendorong kemampuan AI dalam menghasilkan konten natural dan persuasif. Di sisi lain, muncul kebutuhan mendesak untuk mendeteksi konten yang dihasilkan AI.

Karena perlombaan yang tak akan pernah usai ini, WITNESS mengusulkan pergeseran paradigma dari metrik teknis semata (seperti akurasi dan kecepatan) ke pendekatan sosioteknis yang lebih komprehensif.

Kerangka kerja TRIED mengevaluasi alat deteksi AI berdasarkan enam pilar inti yang saling berhubungan, memastikan alat tersebut inovatif dan relevan dengan konteks dunia nyata:

1. Alat Deteksi AI Menghadapi Tantangan di Dunia Nyata

Alat harus beradaptasi dengan jenis media sintetis yang baru muncul, berkinerja baik pada media berkualitas rendah, menangani artefak audio yang beragam, dan dilatih dengan data beragam yang mencakup berbagai jenis file, kompresi, dan format aplikasi media sosial.

Pertanyaan kunci: Apakah alat ini bisa bekerja dengan baik pada video yang kualitasnya rendah atau sudah dikompresi dari media sosial? Apakah alat ini dilatih dengan data dari berbagai bahasa dan aksen, atau hanya bahasa Inggris?

Contoh penerapan: Jika video pidato politikus yang Anda periksa adalah rekaman ponsel yang buram atau diunggah ulang berkali-kali di WhatsApp, apakah alat ini masih bisa memberikan hasil yang akurat? Jika politikus berbicara dalam bahasa daerah, apakah alat ini memiliki data pelatihan yang relevan untuk mendeteksi manipulasi suara dalam bahasa tersebut?

2. Mempromosikan Transparansi dan Penjelasan Hasil Deteksi

Alat harus memberikan informasi yang jelas, terperinci, dan berbasis bukti. Ini termasuk menjelaskan data pelatihan, batasan alat (misalnya, kualitas media), lokalisasi temporal (mengidentifikasi momen atau wilayah manipulasi tertentu), dan pembaruan alat. Penting untuk menghindari label biner (“nyata” atau “palsu”) dan sebaliknya menawarkan deskripsi bernuansa.

Pertanyaan kunci: Ketika alat ini memberikan hasil, apakah ia hanya mengatakan “ini palsu” atau “ini asli”? Atau apakah ia menjelaskan mengapa? Apakah ia menunjukkan bagian mana dari video yang dicurigai dimanipulasi?

Contoh penerapan: Jika alat mendeteksi video itu sebagai deepfake, apakah ia menjelaskan “skor kepercayaan”nya? Apakah ia menunjukkan area wajah atau bagian suara yang paling mungkin dimanipulasi? Apakah ia juga menjelaskan batasan analisisnya, misalnya jika kualitas video terlalu rendah untuk hasil yang sangat pasti?

3. Memastikan Alat Deteksi AI Dapat Diakses oleh Pengguna

Aksesibilitas mencakup pertimbangan pengetahuan teknis yang diperlukan, keterjangkauan, fungsionalitas offline, dan kebijakan privasi data yang jelas. Alat harus melayani pengguna dengan tingkat keahlian teknis yang bervariasi dan tidak membatasi akses karena biaya atau konektivitas.

Pertanyaan kunci: Apakah alat ini mudah digunakan oleh jurnalis yang mungkin tidak punya latar belakang teknis mendalam? Apakah alat ini gratis atau terjangkau? Bisakah publik menggunakannya tanpa koneksi internet yang kuat?

Contoh penerapan: Apakah antarmuka alat ini intuitif? Apakah ada panduan penggunaan yang jelas? Jika saya berada di daerah dengan internet yang tidak stabil, apakah alat ini memiliki fitur offline atau membutuhkan daya komputasi yang besar?

4. Keadilan Sepanjang Proses Pengembangan dan Distribusi

Keadilan memerlukan data pelatihan yang beragam secara demografis dan linguistik, pengumpulan data yang etis, kepatuhan terhadap peraturan privasi data, pendekatan pengujian yang holistik (melibatkan tim eksternal yang beragam), dan kinerja yang konsisten di berbagai demografi dan konteks.

Pertanyaan kunci: Apakah alat ini adil dalam mendeteksi deepfake pada orang-orang dari berbagai latar belakang etnis atau warna kulit? Apakah data pelatihannya mencakup keragaman demografi global?

Contoh penerapan: Jika politikus dalam video memiliki warna kulit gelap atau berasal dari etnis minoritas, apakah alat ini tetap akurat atau justru cenderung salah mendeteksi seperti yang terjadi pada contoh politikus Ghana di Canvas?

5. Berinvestasi dalam Ketahanan Deteksi

Alat harus diperbarui dan dipelihara secara teratur agar tetap efektif seiring dengan semakin canggihnya media sintetis. Ini mencakup pengujian rutin, kemampuan beradaptasi terhadap teknologi yang muncul, ketahanan terhadap serangan adversarial, dan protokol penghentian yang jelas untuk alat yang tidak lagi didukung.

Pertanyaan kunci: Seberapa sering alat ini diperbarui? Apakah pengembangnya terus melatihnya dengan jenis deepfake terbaru yang semakin canggih? Apakah ada rencana jika alat ini tidak lagi didukung?

Contoh penerapan: Jika ada teknologi deepfake baru muncul, apakah alat ini akan segera diperbarui untuk bisa mendeteksinya? Apakah ada informasi kapan terakhir kali alat ini dimutakhirkan?

6. Integrasi Alat dalam Ekosistem Verifikasi yang Lebih Luas

Alat deteksi AI harus dilihat sebagai bagian dari teka-teki verifikasi yang lebih besar, melengkapi metode lain seperti analisis citra satelit, kesaksian saksi, dan penelusuran konteks. Mereka harus mendukung alur kerja verifikasi yang ada dan tidak memposisikan diri sebagai solusi definitif.

Pertanyaan kunci: Apakah alat ini mendorong pengguna untuk juga menggunakan metode verifikasi lain (misalnya, mencari sumber asli, membandingkan dengan berita lain, atau mencari saksi mata)?

Contoh penerapan: Setelah alat ini memberikan hasil, apakah ia menyarankan untuk melakukan langkah-langkah verifikasi tambahan, seperti memeriksa konteks pidato atau mencari informasi dari sumber-sumber terpercaya lainnya, alih-alih hanya mengandalkan hasil alat ini saja?

Seruan untuk Bertindak

Laporan ini menyerukan tindakan nyata bagi pengembang dan pembuat kebijakan. Pengembang detektor didorong untuk merancang alat yang adaptif, mudah digunakan, dan memanfaatkan keragaman data.

Perlu ada badan standar yang menetapkan pedoman tentang transparansi, penjelasan, dan pembaruan sistem. Badan pengatur internasional dan domestik harus memperkuat struktur akuntabilitas dan berinvestasi dalam melek media.

Terakhir, pemerintah dan parapihak dalam industri ini harus meningkatkan investasi dalam teknologi deteksi AI dan evaluasi sosioteknis, sekaligus memperkuat kerangka akuntabilitas dan mendukung program pelatihan.

Tolok Ukur TRIED ini diharapkan dapat menciptakan dan menilai alat deteksi yang benar-benar operasional di dunia nyata, berkontribusi pada penegakan kepercayaan, mendorong akuntabilitas, dan memperkuat ekosistem informasi global dari ancaman media sintetis yang menipu.

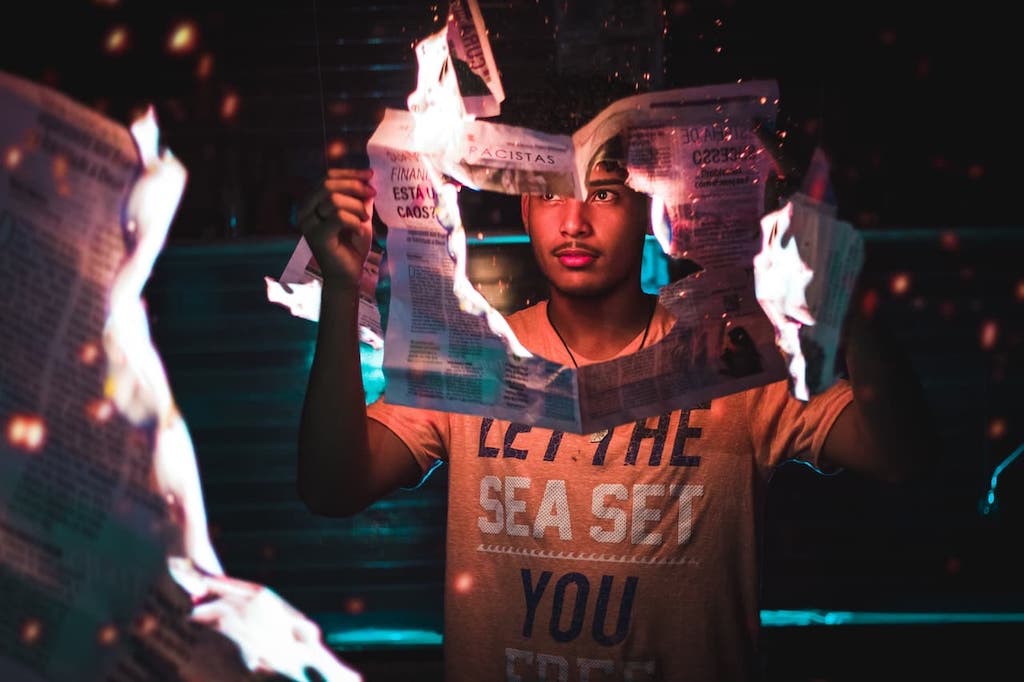

*Photo by Vardan Papikyan on Unsplash