Model-model akal imitasi (AI) terkemuka belum bisa mendeteksi hate speech atau ujaran kebencian secara akurat dari konten yang beredar di media sosial. Model yang sudah mampu mendeteksi masih menghadapi masalah inkonsistensi yang serius.

Sebuah riset dari University of Pennsylvania baru-baru ini mengungkap celah serius: model-model AI terkemuka masih sangat inkonsisten dalam mengidentifikasi ujaran kebencian. Hal ini menimbulkan pertanyaan tentang upaya mendeteksi serangan verbal online.

Studi dipimpin oleh peneliti dari Annenberg School for Communication, University of Pennsylvania, memberikan sorotan tajam pada celah kritis dalam moderasi konten berbasis kecerdasan buatan atau akal imitasi (AI).

Riset yang berjudul “Model-Dependent Moderation: Inconsistencies in Hate Speech Detection Across LLM-based Systems,” secara khusus menguji bagaimana model-model AI terkemuka, termasuk yang dikembangkan oleh OpenAI, Google, dan DeepSeek, mendeteksi ujaran kebencian.

Peneliti menguji tujuh model AI yang berbeda, menyajikan konten ujaran kebencian yang sama kepada setiap model untuk melihat bagaimana klasifikasi mereka. Hasilnya menunjukkan apa yang satu model tandai sebagai ujaran berbahaya, model lain bisa menganggapnya sebagai biasa saja.

Yphtach Lelkes, seorang profesor di UPenn menuturkan, “Riset kami menunjukkan ketika menyangkut ujaran kebencian, [mesin] AI sangat tidak konsisten. Implikasinya adalah bentuk baru dari sensor digital di mana aturannya tidak terlihat, dan wasitnya adalah mesin.”

Temuan dari University of Pennsylvania ini memiliki implikasi luas bagi platform media sosial, pemerintah, dan publik. Dengan AI yang harapan dalam moderasi konten, ketidakseragaman ini dapat mengikis kepercayaan publik dan menciptakan persepsi bias.

Selain itu, temuan tersebut menekankan AI bukan solusi tunggal untuk masalah ujaran kebencian. Penggunaan bahasa yang lebih halus dan terselubung oleh para pelaku menunjukkan AI, meskipun terus diperbarui, masih tertinggal dalam permainan “kucing-dan-tikus” ini.

Perbedaan Metode AI, Inkonsistensi Pada Hasil

Inkonsistensi deteksi oleh beragam mesin, seperti diungkap PsyPost, paling terasa pada ujaran yang menargetkan kelompok berdasarkan kelas ekonomi atau minat pribadi. Ini berbeda dengan deteksi yang lebih konsisten pada ujaran yang menargetkan ras atau gender.

Deteksi terhadap ujaran kebencian yang menargetkan kelompok berdasarkan ras, gender, atau orientasi seksual cenderung lebih konsisten di antara model-model yang berbeda. Meski, bisa berbeda antar model, tingkat perbedaannya lebih tipis.

Namun, inkonsistensi meningkat secara dramatis ketika konten menargetkan kelompok berdasarkan atribut yang kurang “tradisional” atau lebih bernuansa, seperti tingkat pendidikan, minat pribadi, atau kelas ekonomi.

Hal ini, menurut PsyPost, membuat beberapa komunitas menjadi lebih rentan terhadap bahaya online karena mereka tidak menerima tingkat perlindungan yang dapat diprediksi dari sistem otomatis—bila diimplementasikan pada platform.

Studi ini juga menemukan bahwa model-model AI tidak hanya memiliki skor yang berbeda, tetapi juga “titik ambang” atau batas keputusan internal berbeda untuk menentukan apakah suatu konten secara resmi melewati batas menjadi ujaran kebencian.

Ini mengindikasikan perbedaan filosofi moderasi yang mendasar. Sebagai contoh, beberapa sistem AI mengandalkan kehadiran kata-kata makian untuk secara otomatis menandai konten sebagai ujaran kebencian.

Di sisi lain, ada model yang lebih fokus pada sentimen keseluruhan dari kalimat, yang menyebabkan ketidakcocokan dalam penilaian. Peneliti memberikan contoh pada sebuah kalimat yang menggabungkan kata makian rasial dengan bahasa positif (ambiguitas).

Contohnya, seperti “Semua [MAKIAN] adalah orang-orang hebat,” ditandai berbeda oleh model yang berbeda—sebagian menganggapnya sebagai ujaran kebencian karena adanya kata MAKIAN, sementara yang lain menganggapnya dapat diterima karena kata HEBAT sentimennya positif.

Mengonfirmasi Temuan Sebelumnya

Penelitian serupa pernah digaungkan oleh akademisi di Indonesia. Sejumlah studi dari universitas lokal menunjukkan bahwa algoritma AI memiliki kesulitan dalam memahami konteks multilingual dan multidomain, yang sangat umum dalam komunikasi di media sosial Indonesia.

Sebuah studi dari Universitas Muhammadiyah Surakarta menjelaskan bahwa kerumitan bahasa di Indonesia, dengan pencampuran bahasa daerah, nasional, dan asing dalam satu postingan, menjadi tantangan besar.

Mereka menemukan bahwa tantangan ini diperparah oleh kerumitan bahasa dan budaya lokal. Meskipun model AI dapat belajar dari data, kemampuan mereka seringkali terbatas pada satu bahasa saja, sehingga gagal saat dihadapkan pada konten yang campur aduk.

Penelitian oleh Muhammad Okky Ibrohim dan Indra Budi dari Fakultas Ilmu Komputer Universitas Indonesia (Fasilkom UI) pernah mengembangkan pendeteksi ujaran kebencian di Twitter dengan akurasi 77,36%, namun mengakui adanya keterbatasan, terutama pada ujaran provokatif.

Masalah bias dalam data pelatihan menjadi inti dari kegagalan AI, baik di ranah global maupun lokal. Algoritma AI seringkali memperkuat bias yang sudah ada dalam data historis yang mereka pelajari.

Di TikTok misalnya, algoritma dapat memperkuat stereotip atau diskriminasi terhadap kelompok tertentu yang kurang terwakili dalam data pelatihan, terutama terkait isu intoleransi agama. Demikian pula moderasi AI di platform seperti Roblox yang dinilai belum efektif melindungi anak.

Lebih dari itu, kegagalan ini juga memicu risiko “over-moderation” di mana AI keliru memblokir konten yang sebenarnya tidak berbahaya. Jurnal dari Center for Indonesian Policy Studies (CIPS) menyoroti bahwa kebijakan moderasi konten yang berlebihan dapat menghambat pertumbuhan ekonomi digital.

Di sisi lain, laporan dari Aliansi Jurnalis Independen (AJI) menekankan pentingnya standar etika yang ketat dan transparansi dalam penggunaan AI oleh media, guna menjaga integritas jurnalistik dan kepercayaan publik.

Tanpa pengawasan manusia, keputusan AI dapat menjadi “kotak hitam” yang tidak memberikan penjelasan, membuat pengguna kesulitan mengajukan banding, seperti yang dibahas dalam jurnal dari Journal UII.

Selaras dengan hasil riset di UPenn, akademisi internasional maupun lokal tampaknya sepakat AI tidak dapat sepenuhnya menggantikan peran manusia. Makalah dari Cambridge Consultants menyatakan “tidak mungkin sepenuhnya mengotomatisasi moderasi konten yang efektif.”

Solusi yang paling menjanjikan adalah pendekatan hibrida, yang menggabungkan kecepatan dan skalabilitas AI dengan kemampuan unik manusia untuk memahami konteks, nuansa, dan budaya.

Perpaduan ini diharapkan dapat menciptakan lingkungan digital yang lebih aman, adil, dan sejalan dengan nilai-nilai lokal, sembari mengatasi tantangan yang ditimbulkan oleh ujaran kebencian di era digital.

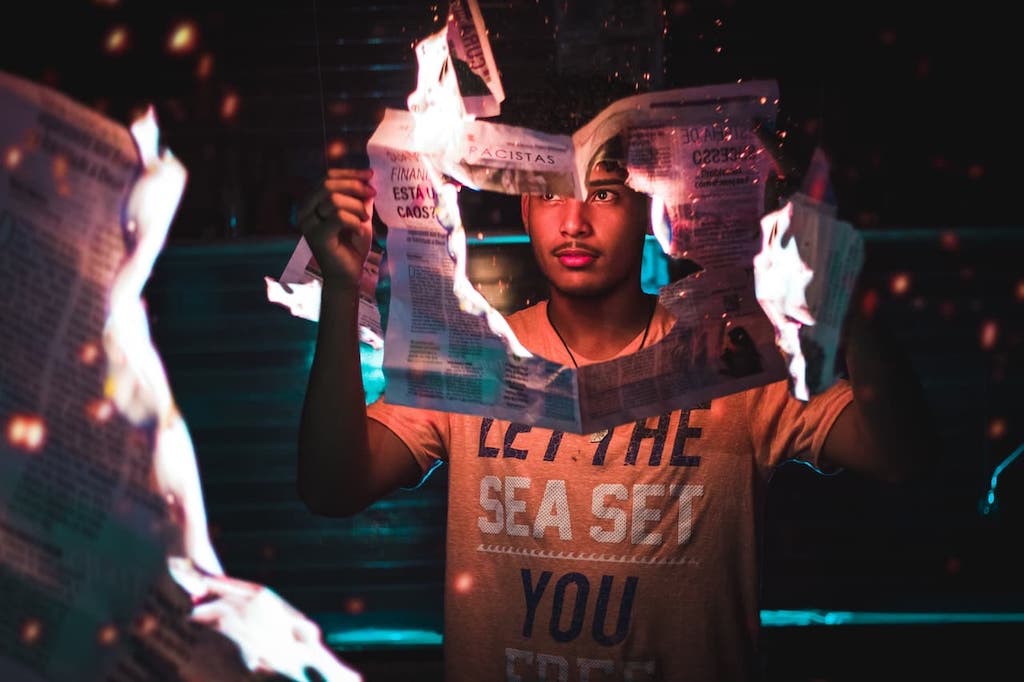

*Photo by RDNE via Pexels

Thank you for information !

Thanks for information

Regards, Unissula